A cada ano, cerca de 7 milhões de crianças são denunciadas às autoridades de bem-estar infantil por possível abuso, mas como as autoridades determinam se as crianças gostam Gabriel fernandez estão em grave perigo e precisam de intervenção?

Muitas autoridades de bem-estar infantil confiam nas avaliações de risco fornecidas por funcionários treinados para atender as linhas de telefone onde há denúncias de suspeita de abuso, mas alguns acreditam que pode haver uma maneira melhor.

“Há uma vasta literatura que vimos sugerir que os humanos não são bolas de cristal particularmente boas”, Emily Putnam-Hornstein, diretora do Rede de Dados Infantis e um professor associado da USC, disse na nova série de documentos do Neflix “The Trials of Gabriel Fernandez”. “Em vez disso, o que estamos dizendo é que vamos treinar um algoritmo para identificar quais dessas crianças se encaixam em um perfil em que o risco de arco longo sugere envolvimento futuro do sistema.”

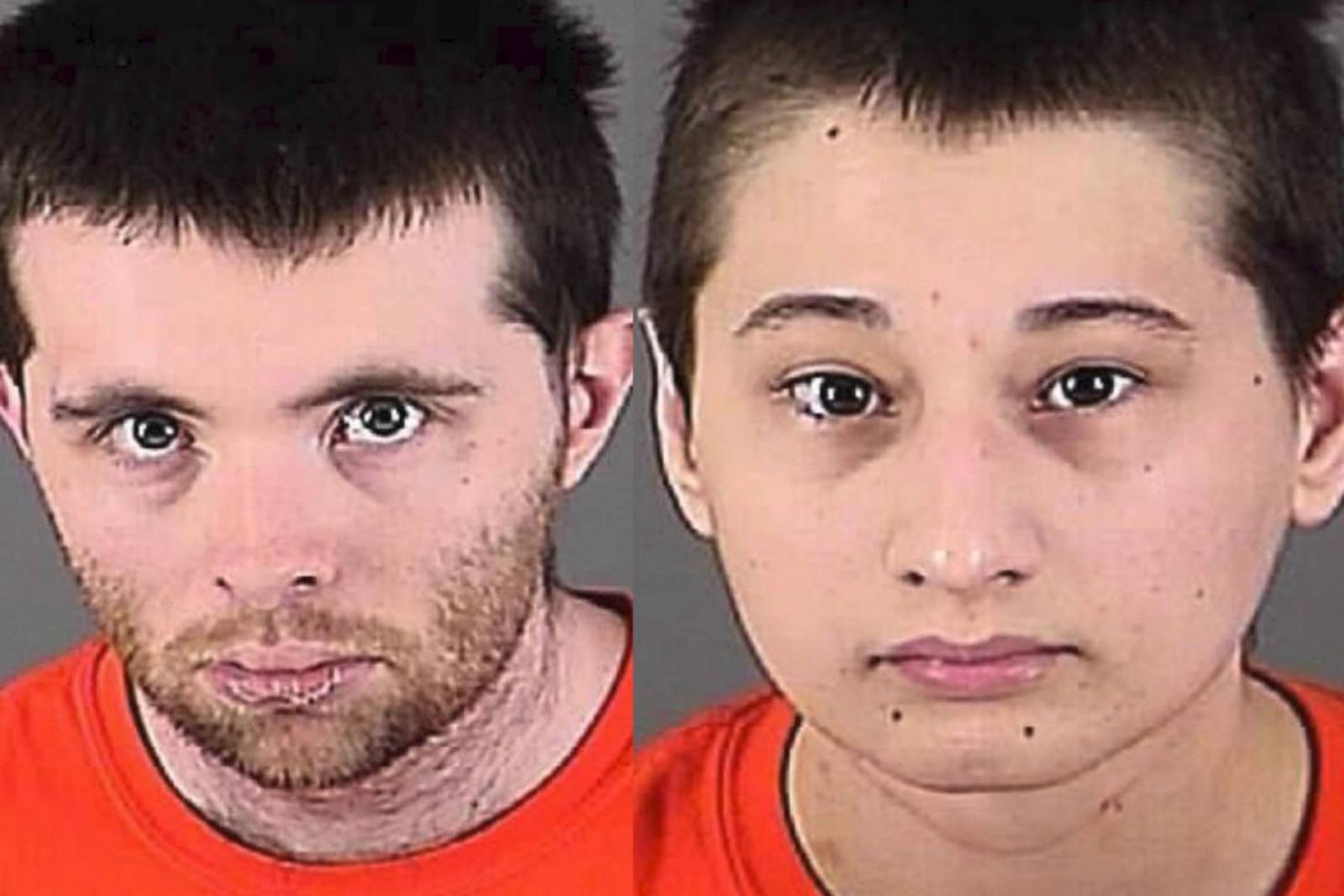

Fernandez era um menino de 8 anos espancado e torturado até a morte por seu mãe e ela namorado , apesar dos repetidos telefonemas de seu professor e outros às autoridades que relataram suspeitas de abuso. A nova série de seis partes examina a vida e a morte horrível de Fernandez, mas também dá uma olhada em problemas sistêmicos dentro do sistema de bem-estar infantil que poderia ter desempenhado um papel.

Putnam-Hornstein argumenta que uma estratégia para identificar mais efetivamente as crianças que estão em maior risco poderia ser o uso de algoritmos especialmente criados que usam registros administrativos e mineração de dados para determinar as pontuações de risco para cada criança.

“Na verdade, temos cerca de 6 ou 7 milhões de crianças que são denunciadas por suposto abuso ou negligência todos os anos nos EUA e, historicamente, a forma como tomamos algumas de nossas decisões de triagem se baseia apenas em avaliações instintivas”, disse ela. “A modelagem de risco preditiva é apenas dizer,‘ Não, não, não, vamos dar uma abordagem mais sistemática e empírica para isso. ’”

Putnam-Hornstein e Rhema Vaithianathan, o codiretor do Centro de análise de dados sociais , conseguiram colocar a ideia em prática no condado de Allegheny, na Pensilvânia. A dupla usou milhares de referências de maus-tratos infantis para projetar um algoritmo que determinaria uma pontuação de risco para cada família relatada aos serviços de proteção à criança do condado, de acordo com o Center For Health Journalism .

“Há uma centena de fatores diferentes que são examinados”, explicou Marc Cherna, diretor do Departamento de Serviços Humanos do condado de Allegheny, na série de documentos. “Alguns exemplos básicos são a história do bem-estar infantil, a história dos pais, certamente o uso de drogas e vício, doença mental familiar, prisão e condenações e, especialmente, se houver agressões e coisas assim.”

Devido ao grande volume de chamadas, as autoridades de bem-estar infantil em todo o país têm a tarefa de determinar se uma família deve ser triada para investigação com base na reclamação ou excluída.

Em 2015, 42% das 4 milhões de denúncias recebidas em todo o país envolvendo 7,2 milhões de crianças foram rastreadas, de acordo com O jornal New York Times .

No entanto, crianças continuam a morrer de abuso infantil.

O sistema que está sendo usado no Condado de Allegheny foi projetado para prever com mais precisão quais famílias provavelmente terão envolvimento futuro com o sistema por meio da análise de dados.

“O que os rastreadores têm são muitos dados”, disse Vaithianathan ao The Times. “Mas é muito difícil navegar e saber quais fatores são mais importantes. Em uma única chamada para C.Y.F. , você pode ter dois filhos, um suposto perpetrador, você terá mãe, você pode ter outro adulto na casa - todas essas pessoas terão histórias no sistema que a pessoa que está rastreando a ligação pode investigar. Mas o cérebro humano não é tão hábil em controlar e dar sentido a todos os dados. ”

A ferramenta de triagem da família Allegheny usa uma técnica estatística chamada 'mineração de dados' para observar os padrões históricos para 'tentar fazer uma previsão sobre o que pode acontecer' em qualquer caso, disse ela na série de documentos.

Cada caso recebe uma pontuação de risco que varia de um a 20 - categorizando cada caso como de alto risco, médio risco ou baixo risco.

Rachel Berger, uma pediatra do Hospital Infantil de Pittsburgh, disse ao The Times em 2018 que o que torna a análise preditiva valiosa é que ela elimina parte da subjetividade que normalmente entra no processo.

“Todas essas crianças estão vivendo no caos”, disse ela. “Como o C.Y.F. escolher quais estão mais em perigo quando todos têm fatores de risco? Você não pode acreditar na quantidade de subjetividade que entra nas decisões de proteção à criança. É por isso que adoro análises preditivas. Está finalmente trazendo alguma objetividade e ciência para decisões que podem ser tão incrivelmente transformadoras de vidas. ”

Mas também houve críticos que argumentam que o uso de análises preditivas depende de dados que já podem ser tendenciosos. Pesquisas anteriores mostraram que as minorias e famílias de baixa renda são freqüentemente super-representadas nos dados coletados, potencialmente criando um preconceito contra as famílias afro-americanas ou outras famílias minoritárias, de acordo com a série docu.

“Os preconceitos humanos e os preconceitos de dadosandem de mãos dadas com os outros, ”Kelly Capatosto, pesquisadora associada sênior do Instituto Kirwan para o Estudo de Raça e Etnia da Universidade Estadual de Ohio, disse, de acordo com o Center for Health Journalism. “Com essas decisões, pensamos na vigilância e no contato do sistema - com a polícia, agências de assistência à infância, quaisquer agências de assistência social. Vai ser super-representado em comunidades (de baixa renda e minorias). Não é necessariamente indicativo de onde essas instâncias estão ocorrendo. ”

Erin Dalton, vice-diretora do escritório de análise, tecnologia e planejamento do condado de Allegheny, admitiu que o preconceito é possível.

“Com certeza há preconceito em nossos sistemas. O abuso infantil é visto por nós e nossos dados não como uma função do abuso infantil real, é uma função de quem é denunciado ”, disse ela na série Netflix.

Mas o condado também disse ao Center for Health Journalism que descobriu que receber benefícios públicos reduz as pontuações de risco para quase todas as famílias.

TO condado é “muito sensível” a essa preocupação e está fazendo uma análise contínua do sistema para determinar se os grupos foram visados de forma desproporcional, Cherna também disse na série de documentos.

O sistema do condado de Allegheny é propriedade do próprio condado, mas também houve algumas críticas a outros sistemas de triagem de propriedade privada.

O Departamento de Serviços para Crianças e Famílias de Illinois anunciou em 2018 que não usaria mais um pacote de análise preditiva desenvolvido pela Eckerd Connects, uma organização sem fins lucrativos, e seu parceiro com fins lucrativos MindShare Technology, em parte porque a empresa se recusou a fornecer detalhes sobre quais fatores estavam sendo usados em sua fórmula, de acordo com o The Times.

O sistema supostamente começou a designar milhares de crianças como necessitando de proteção urgente, dando a mais de 4.100 crianças de Illinois 90 por cento ou mais probabilidade de morte ou ferimentos, The Chicago Tribune relatado em 2017.

três marcas de mordidas em fotos da cena do crime de West Memphis

Mesmo assim, outras crianças que não receberam pontuação de alto risco acabaram morrendo por abuso.

'Análise preditiva (não estava) prevendo nenhum dos casos graves', diretor do Departamento de Crianças e Serviços à Família, Beverly “B.J.” Walker disse ao Tribune. 'Decidi não prosseguir com esse contrato.'

Daniel Hatcher, autor de “ A Indústria da Pobreza: A Exploração dos Cidadãos Mais Vulneráveis da América ”Comparou alguns dos sistemas analíticos a uma“ caixa preta ”, dizendo na série de documentos que como eles tomam suas decisões nem sempre é claro.

“Eles não têm como descobrir como estão realmente decidindo um nível de atendimento que tem um grande impacto sobre o indivíduo”, disse ele.

Putnam-Hornstein reconheceu que os sistemas analíticos preditivos não são capazes de determinar o comportamento futuro, mas ela acredita que é uma ferramenta valiosa que permite aos responsáveis pela triagem tomar decisões mais informadas sobre quais crianças podem estar em maior risco.

“Minha esperança é que esses modelos ajudem nosso sistema a prestar mais atenção ao subconjunto relativamente pequeno de referências, onde o risco é particularmente alto, e poderemos dedicar mais recursos a essas crianças e famílias de forma preventiva”, disse ela, de acordo com ao Centro de Jornalismo em Saúde. “Eu não quero que ninguém exagere na modelagem de risco preditivo. Não é uma bola de cristal. Não vai resolver todos os nossos problemas. Mas, na margem, se nos permitir tomar decisões um pouco melhores e identificar os casos de alto risco e separá-los dos casos de baixo risco e ajustar de acordo, isso pode ser um desenvolvimento importante para o campo ”.